智能技术之患:机器与人的战争,还是人与人的战争? | 土逗思

作者 | 熊节

编辑 | 屐松松

美编 | 黄山

人工智能的风险讨论已经不再是新话题。在过去几年中,很多研究者提及了人工智能(以及与之紧密相关的技术,尤其是机器学习和大数据技术)可能带来的危害与风险。值得注意的现象是:在公众话语空间中,所流行的关于智能技术伦理危害与风险的讨论,大多将“人类”整体视为潜在的被害对象,大量的叙事被构建为“机器VS人类”的形式。

关于智能技术如何被当前的社会权力结构所主导,并反过来强化该结构,从而加深对弱势边缘群体的压迫,相关的讨论数量较少,且缺乏系统性。本文将展开关于智能技术伦理危害与风险的介绍,并着重讨论其如何强化社会与经济的不公正。

想象未来世界:全人类被毁灭的讨论

有关智能技术伦理危害与风险,部分讨论已进入流行文化空间,引起了大众的兴趣。通常,其以未来学的形式示人:试图推测人工智能技术成熟、尤其具备了自我完善的能力之后的未来图景。如超级智能、人工智能毁灭人类[1]、技术奇点[2]等讨论,引发了大众对其中伦理问题的广泛关注。

相关的讨论占据畅销行列,大众对人工智能的伦理问题也开始关注。图片来源:网络

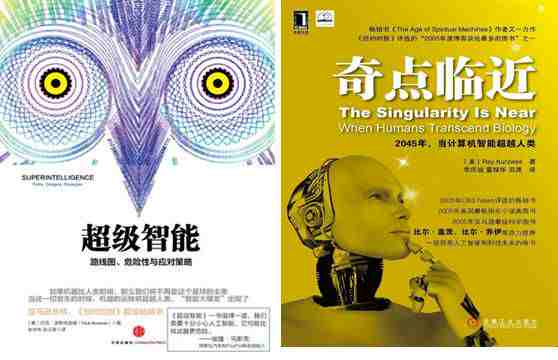

比起事关人类存亡、略带科幻感的宏大叙事,另一些相关的伦理危害与风险,正在更加现实中发生。例如智能技术对就业的影响,是一个经常被提及的主题。Kevin Kelly认为[3],机器在工作中对人的取代是一个不可逆的过程,有一些工作暂时只有人类能做或做得比机器更好,但机器终将胜过人类,绝大多数人类在几十年后,将不再需要从事生产工作。麦肯锡的一个研究[4],具体地列出了各种职业被机器取代的可能性,其中生产线工作、准备食物、包装物品等“可预测的物理工作”是最容易被机器取代的。

麦肯锡的报告更近一步,分析了哪些职业将被替代。图片来源:麦肯锡

除了造成大面积结构性失业外,人们还担忧[5],赛博空间和物理空间的战争:控制了大量资源甚至自动化武器的人工智能,是否会攻击它们本不应该攻击的对象?这种危险甚至不必以战争的形式出现:考虑到它们已经在社会经济中扮演如此重要的角色,其错误行为(甚至只是不恰当的优化)是否会造成极端恶劣的结果?可以注意到,以上几类常见的讨论,总体上强调人工智能对人类整体的影响,并不凸显其对当前社会不同人群所造成的不同影响。

同样的趋势,也出现在对智能技术风险的分析中。众多此类分析聚焦于技术层面,而并未将社会和政治因素纳入考虑。例如斯坦福大学的研究者认为,通过机器学习尤其是深度学习得到的统计学模型,具有以下特征及安全隐患:

•不透明:很难、甚至根本无法看懂其中的逻辑;

•整体不可分:无法通过局部分拆理解输入输出之间的关系;

•脆弱:输入的微小变化可能引起输出的重大且无法预测的变化;

•不被充分理解。

作为对比,Weapons of Math Destruction一书作者Cathy O’Neil也提到了众多智能算法工具的危险的特征[6],其广泛影响着人们的日常工作与生活:

•它们是秘密的,经常是某家公司的商业秘密;

•它们是不透明的,被它们影响的人群不了解这些算法如何运行;

•它们应用的范围很广;

•它们对“成功”的定义值得置疑,被它们影响的人们未必赞同;

•它们制造了有害的反馈环。

未来世界也在折叠?

相比前一组特征,O’Neil识别的特征具有一个值得注意的要点:特定的人群。她指出了一个极其重要、但绝非总是明显的问题:智能技术对人的影响是有区别的,同一个技术可能让一部分人受益、同时让另一部分人受损。2010年在伊利诺伊州开始实施的教师绩效评估算法,引发了芝加哥教师的广泛反对乃至游行抗议[7],这就是一个实例。

芝加哥教师反对教师绩效评估的算法,图片来源:网络

正如Linnet Taylor不无洞见地指出[8],在进行伦理评估时,人们倾向于抽象地谈论智能技术可能造成的伤害,而具体地谈论它带来的收益,于是实在的收益总能压倒模糊未知的伤害,从而使项目通过评估。通过将社会和政治因素纳入讨论范围,O’Neil所提出的对具体人群的关注,给了我们一个重要的视角,来重新审视智能技术可能带来的损害和风险。

自此,我们首先可以注意到,智能技术对劳动力市场的影响并非均质。Erik Brynjolfsson和Andrew McAfee在《与机器赛跑》中指出,教育程度较低、薪酬较低的劳动者更易被智能技术取代,同时他们也更难以获得新的职业技能,因而这群劳动者在结构性失业中受到的损害被加重;Paul Krugman一针见血地指出[9],全能且高效的工作机器人(workbot)的出现,未必会让世界变得美好,因为没有能力拥有机器人的那些人,处境将非常悲惨。尽管这方面的研究还很少,但现有的一些研究显示:在高度自动化、智能化的工作环境下,教育和技能水平较低的劳动者,正在面临劳动环境恶化、劳动强度增大、收入降低、缺乏劳动和社会保障等挑战,此种现象在“分享经济”形态中普遍可见[10]。在一些极端的情况下,劳动者被异化成“数字机器上的幽灵”[11]和“生产线上的奴隶”。

作者邱林川讨论了新形势下的奴隶—i奴,图片来源:网络

另外,智能技术可能正在加深对社会弱势群体的偏见和歧视。Wendy Chun认为“机器学习就像偏见的洗钱”[12],通过机器学习,偏见和歧视被包装成模型和算法,使不公正变得更加隐秘而影响深远:职场社交网站LinkedIn的搜索引擎更青睐男性求职者[13],Google的广告平台Adsense存在种族偏见[14],饱受争议的“预测性执法”(predictive policing)对非裔美国人和穆斯林形成结构性歧视[15],低收入人群会因为智能技术更难从贫困中逃脱[16]。性别、种族、宗教信仰、收入……现实中的各种偏见与歧视,似乎都在智能技术中找到了落脚点。

除此以外,智能技术还被被用于控制大众情绪。通过操控用户从新闻订阅渠道看到的信息[17],Facebook成功地调节了用户发帖的情绪,从而证明情绪可以在大量在线用户之间传染。一份曝光的材料[18]显示,JTRIG(联合威胁研究智能小组,隶属于英国情报和国家安全机关政府通信总部)已经在通过Youtube、Facebook、Twitter、博客、论坛、电子邮件、短信、自建网站等渠道操纵大众情绪,从而消除“犯罪、安全和国防威胁”。在政治领域,智能技术可以诱导选民做出片面的判断(Cathy O’Neil在2015年的发言);而在商业领域,其向消费者灌输消费理念,使他们成为对不断更新换代的消费品上瘾的“被制造的奴隶”(manufactured slave)。

JTRIG(Joint Threat Research Intelligence Group)是GCHQ(Government Communications Headquarters政府通讯总部)的一部分,图片来源:网络

早在1980年代中期,研究者们就围绕“计算机伦理是否具有独特性”这一问题展开讨论。Johnson认为[19],计算机伦理只是把标准的道德问题以新形式呈现,逼迫我们在新的领域中延续旧的道德规范,它本身不是一个独特的新题目。而James Moor则认为[20],计算机会大幅度转化/强化现有的伦理问题,并且造成过去未曾出现过的新伦理问题,因此计算机伦理本身就是一个独特的新题目。

这两种观点,对于我们全面认识智能技术的伦理问题,有着重要的启发意义。我们既需要充分了解智能技术的独特性,及其对伦理问题带来的独特影响,又必须认清新技术背后潜藏的旧有冲突、斗争和伦理准则,这样才能准确把握智能技术的伦理方向,使其向着对广大民众有益的方向发展。

(熊节,ThoughtWorks总监咨询师)

注:

[1] 相关的讨论可见:

https://futureoflife.org/background/benefits-risks-of-artificial-intelligence/,作者讨论了人工智能的优点及其风险。

[2] 技术奇点(Technological Singularity)出自奇点理论,一个根据技术发展史总结出的观点,认为未来将要发生一件不可避免的事件──技术发展将会在很短的时间内发生极大而接近于无限的进步。作者推荐阅读

https://www.washingtonpost.com/opinions/matt-miller-artificial-intelligence-our-final-invention/2013/12/18/26ed6be8-67e6-11e3-8b5b-a77187b716a3_story.html?utm_term=.18a112f073bb

[3] Kevin Kelly讨论了为什么我们的工作将会而且一定会被机器人取代,详见:https://www.wired.com/2012/12/ff-robots-will-take-our-jobs/

[4] 麦肯锡季刊发表了关于哪些工作会被取代,哪些工作还不能被取代的研究。详见:

http://www.mckinsey.com/business-functions/digital-mckinsey/our-insights/where-machines-could-replace-humans-and-where-they-cant-yet

[5] 作者讨论了确保人工智能系统安全性的长期及短期的挑战,详见:https://jsteinhardt.wordpress.com/2015/06/24/long-term-and-short-term-challenges-to-ensuring-the-safety-of-ai-systems/

[6] Cathy O'Neil发表演讲讨论大数据如何威胁民主,视频连接:http://boingboing.net/2016/01/06/weapons-of-math-destruction-h.html

[7] 有关芝加哥教师罢工的详情可见:

https://www.revealnews.org/article/the-strike-over-student-growth-chicago-teachers-protest-reflects-a-national-feud/

[8] 具体讨论见:

https://linnettaylor.wordpress.com/2016/11/01/why-datas-not-a-public-good/

[9] Paul Krugman的文章发表于纽约时报,题为《增长结束了吗》,见链接:https://krugman.blogs.nytimes.com/2012/12/26/is-growth-over/?_r=1

[10] 作者推荐参考阅读《警惕分享经济的暗面》,见链接:

http://gigix.thoughtworkers.org/2016/4/30/dark-side-of-sharing-economy/

[11] 参考阅读:

https://www.thenation.com/article/how-crowdworkers-became-ghosts-digital-machine/

[12] 参考阅读第一届网络社会年会主题报告《全喜卿:以同质性治理——作为区隔的网络科学》:http://caa-ins.org/archives/1258

[13] 参考阅读:

http://www.seattletimes.com/business/microsoft/how-linkedins-search-engine-may-reflect-a-bias/

[14] 参考阅读:

https://www.technologyreview.com/s/510646/racism-is-poisoning-online-ad-delivery-says-harvard-professor/

[15] 参考阅读:

http://www.cnsnews.com/news/article/barbara-hollingsworth/coalition-predictive-policing-supercharges-discrimination

[16] 参考阅读:

https://www.theatlantic.com/technology/archive/2016/04/how-big-data-harms-poor-communities/477423/

[17] 参考阅读:

http://bdes.datasociety.net/council-output/perspectives-on-big-data-ethics-and-society/

[18] 参考阅读:

https://theintercept.com/2015/06/22/controversial-gchq-unit-domestic-law-enforcement-propaganda/

[19] 观点详见:

http://journals.sagepub.com/doi/abs/10.1177/2053951714559253

[20] 观点详见:

http://faculty.usfsp.edu/gkearns/Articles_Fraud/computer_ethics.pdf,可下载阅读。

本文由作者授权土逗公社发布

转载请联系作者

土逗思

为热点事件注入冷静思考,

向思想先哲撷取智慧精华,

关注新书、新文化、新趋势……

土逗思期待与你碰撞出思想的火花,

点击关键词查看更多

这里“阅读原文”,查看更多

最新评论

推荐文章

作者最新文章

你可能感兴趣的文章

Copyright Disclaimer: The copyright of contents (including texts, images, videos and audios) posted above belong to the User who shared or the third-party website which the User shared from. If you found your copyright have been infringed, please send a DMCA takedown notice to [email protected]. For more detail of the source, please click on the button "Read Original Post" below. For other communications, please send to [email protected].

版权声明:以上内容为用户推荐收藏至CareerEngine平台,其内容(含文字、图片、视频、音频等)及知识版权均属用户或用户转发自的第三方网站,如涉嫌侵权,请通知[email protected]进行信息删除。如需查看信息来源,请点击“查看原文”。如需洽谈其它事宜,请联系[email protected]。

版权声明:以上内容为用户推荐收藏至CareerEngine平台,其内容(含文字、图片、视频、音频等)及知识版权均属用户或用户转发自的第三方网站,如涉嫌侵权,请通知[email protected]进行信息删除。如需查看信息来源,请点击“查看原文”。如需洽谈其它事宜,请联系[email protected]。