下一代亲密聊天机器人将在不需要连接互联网的情况下,以光速在个人笔记本电脑上运行。

这至少是英特尔首席执行官帕特•格尔辛格(Pat Gelsinger)在2023年英特尔创新峰会上提出的愿景。格尔辛格通过在台上演示,宣布“人工智能个人电脑”的问世,该个人电脑可仅依靠用户手上的硬件,加速运行不断增多的各种人工智能任务。

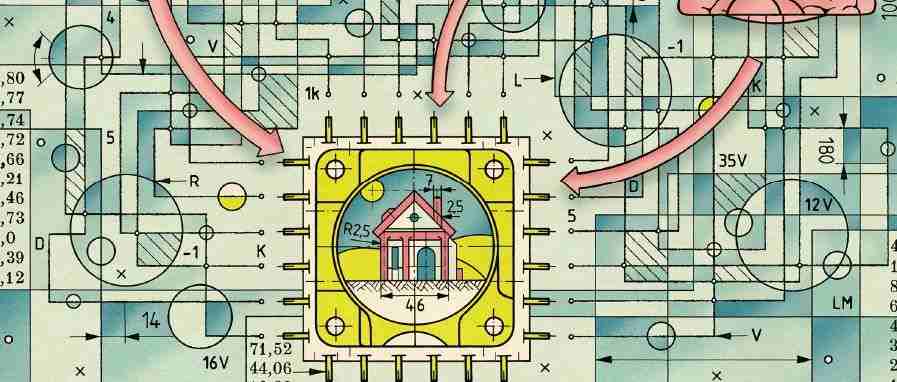

英特尔并不是唯一进行相关研究的公司。包括苹果公司和高通公司在内的消费电子设备科技巨头都在竞相优化其硬件和软件,以便在“边缘环境”(即本地硬件)而不是远程云服务器上运行人工智能。目标是什么呢?那就是天衣无缝的个性化、私人化人工智能,让你完全忘记它是“人工智能”。

2023年是云端人工智能的辉煌一年。微软首席执行官萨蒂亚•纳德拉(Satya Nadella)将小拇指举到嘴边,率先向OpenAI投入100亿美元,创造了ChatGPT和DALL-E。与此同时,谷歌也匆忙在3月推出了自己的聊天机器人Bard;9月,亚马逊宣布向Anthropic投资40亿美元,创造了ChatGPT的竞争对手Claude。

这一切都预示着人工智能将很快在各个方面彻底改变我们的生活,但是这个梦想在边缘环境上被磨损了。如今,强大的人工智能模型在很大程度上要依靠配备昂贵人工智能硬件的数据中心,而远程访问这种基于数据中心的人工智能必然速度很慢。有时ChatGPT对话或DALL-E 2生成的图像等人工智能生成内容可能会出现停滞,因为服务器负担过重,难以跟上。

奥利弗•莱蒙(Oliver Lemon)是爱丁堡赫瑞瓦特大学的计算机科学教授,同时也与他人共同领导着位于爱丁堡的英国国家机器人中心,有处理这个问题的第一手经验。莱蒙在对话式人工智能和机器人方面有着25年的经验,他希望在Spring等机器人中使用最大的语言模型。Spring是其团队的人形机器人助理,在医院引导访客和患者。Spring看似受益于现代大语言模型(LLM),富有创造力,具备人性化的对话功能,而实际上,它暴露出了云端的局限性。

“(ChatGPT-3.5)太慢了,无法在现实世界中部署。较小的本地大语言模型要好得多。我的印象是,非常大的大语言模型太慢,无法用于基于语言的交互。”莱蒙说。他乐观地认为,OpenAI能够找到解决该问题的方法,但需要一个比包罗万象的GPT更小、更灵活的模型。

Spring采用了Vicuna-13B,这是Meta的Llama大语言模型的一个版本,大型模型系统组织的研究人员对其进行了优化。“13-B”表示该模型的130亿个参数,这个数字在大语言模型的世界里很小。最大的Llama模型包含了700亿个参数,OpenAI的GPT-3.5模型包含了1750亿个参数。

减少模型中的参数可以降低训练成本,这对莱蒙这样的研究人员来说是一个不小的优势。此外,还有第二个同样重要的优势,那就是更快的“推理”,减少将人工智能模型应用于新数据(例如生成文本提示或照片)所需的时间。这是机器人或其他人工智能助手必备的能力,能够实时地提供帮助。

“仔细观察就会发现,推理市场实际上比训练市场大得多。进行推理的理想地点是数据所在的地方。”英特尔网络与边缘事业部的企业副总裁帕拉维•马哈詹(Pallavi Mahajan)说,“因为观察什么在驱动人工智能时,你会发现,是我们的笔记本电脑或手机上的应用程序在驱动人工智能。”

作为一款个性化的人工智能助手,Rewind就是这样的应用程序,能够帮助用户检索他们在自己电脑上完成的事情。删除的电子邮件、隐藏的文件和旧的社交媒体帖子都可以通过基于文本的搜索找到。这些数据一旦恢复,就能够以多种方式得到使用。Rewind可以转录视频、在崩溃的浏览器网页中恢复信息,或创建电子邮件和演示文稿的摘要。

马哈詹表示,Rewind在Windows上的应用是开放人工智能开发生态系统OpenVINO的一个例子。它允许开发人员调用本地可用的CPU、图形处理器和神经处理单元(NPU),不需要编写特定的代码,可优化各种硬件的推理性能。苹果的Core ML为开发人员提供了一套类似工具,适用于iPhone、iPad和Mac。

快速本地推理为另一个目标提供了保障:私密,这一目标可能是所有个性化人工智能助手的关键。

Rewind有多种功能。但要实现这些功能,几乎需要访问计算机上发生的所有情况。这并非Rewind所独有。所有个性化人工智能助手都需要广泛了解你的生活,包括很多敏感信息,比如密码、语音和视频记录,以及电子邮件。

通过单独在笔记本电脑上处理训练和推理,Rewind可以解决这个安全问题,其他注重隐私的人工智能助手可能会效仿这种方法。这样做可以展示出更好的性能,在边缘直接改善个性化和私密性。以此为基础,开发人员可以仅借助数据中心的力量来实现功能,然后向那些关心数据去向的人提供橄榄枝。

IDC的研究总监菲尔•索利斯(Phil Solis)认为,2024年是设备人工智能蔓延到消费电子设备的一个关键机遇。“对于智能手机和个人电脑,这些设备支持人工智能和生成式人工智能是一件大事。”索利斯说,“借助基于网络的工具,人们把信息投到网络中……网络只是把所有内容吸进去,然后吐出来给其他人。隐私和安全是实现设备人工智能的重要原因。”

大型语言模型造就了出色的助手,它们的能力可以进入比较模糊的因果推理领域。人工智能模型可以根据提供的信息得出结论,如果提出要求,还可以逐步解释其想法。虽然人工智能对结果的理解程度有待讨论,但其结果是有效的。

初创公司Artly正在使用人工智能咖啡师机器人Jarvis和Amanda,在北美的几个地方制作咖啡(即使按照俄勒冈州波特兰咖啡文化的严格标准,它们也能制作出优质的卡布奇诺咖啡)。该公司的联合创始人兼首席执行官王萌(Meng Wang,音)希望利用大语言模型来让其咖啡师队伍更加智能、更讨人喜欢。

“如果机器人拿杯子时倾斜了,我会告诉它结果是什么。”王萌说。但可以训练大语言模型使其推测出这个结论,并可应用于各种场景。王萌说,机器人不会在云远端进行所有的推理,无论如何,咖啡师机器人还是需要在线连接,验证付款情况,不过,英伟达的图形处理器仍然可以处理设备的计算机视觉任务。

这种混合方法不应被忽略。实际上,Rewind应用程序在概念上也有类似的功能。它能在本地利用用户个人数据进行训练和推理,还能够选择使用ChatGPT执行要求高质量输出的特定任务,例如撰写电子邮件。

不过,即便是被迫依赖本地硬件的设备,也能实现令人印象深刻的效果。赫瑞瓦特大学的莱蒙说,Spring找到了一种方法,即使在Vicuna-13B这种小型本地推理人工智能模型中也能执行惊人的智能任务。虽然其推理无法与GPT相比,但可以训练该模型使用与语境相关的标签,触发预先设置的表示关注的形体动作和表情。

虽然与“人工智能个人计算机”的愿景相比,机器人的同理心似乎是微不足道的,但机器人面临的性能和隐私挑战与下一代人工智能助手所面临的挑战是相同的。这种人工智能助手正在成为现实,但仅能针对非常有限的特定任务。目前,Mac电脑已经可以下载Rewind(很快也可在Windows电脑上使用);新款苹果手表使用了基于人工智能模型的转换器,实现离线使用Siri;三星计划从2025年开始在其新的家用电器产品中嵌入神经网络处理器(NPU);高通公司的新款Snapdragon芯片很快会用于其旗舰手机,它可以完全在智能手机上处理Meta强大的Llama 2大语言模型,而不需要互联网连接或网络浏览器。

“我认为这是一个来回摆动的钟摆。”英特尔的马哈詹说,“过去大约20年里,世界的一切都在转向云端。现在,我们看到钟摆正在摆回来,应用正在转回到边缘。”

作者:Prachi Patel

阅读原文