从Karpathey那里获得灵感,推特上这位工程师居然可视化了GPT的工作流程!

深度学习自然语言处理 原创

作者:pp

作者:pp

OpenAI创始人之一的Karpathy之前曾亲自下场教大家如何动手学习搭建一个小号的GPT模型--minGPT。而最近,推特上一位叫做Brendan Bycroft的工程师从Karpathy那里汲取到了灵感,居然将GPT在推理时候的数学过程进行了可视化(以下简称LLM-viz),还做成了可以交互的网站(https://bbycroft.net/llm)!任何人都可以轻松地跟随动画和一旁的讲解,学习到GPT内部的工作原理。

自回归推理

GPT是Transformer中Decoder-only这一类模型的代表,采用

Next token prediction的方式进行自回归推理。拆解GPT

计算如何进行

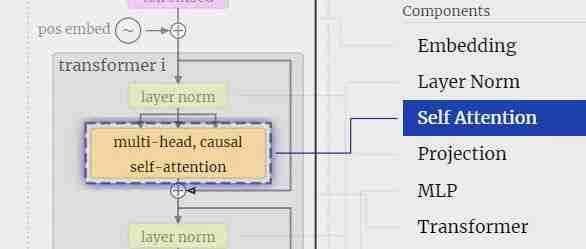

通过LLM-viz,可以看见GPT推理流程的全过程,包括每个计算发生的位置,计算的组成和复杂程度,每个tensor的维度和权值,应有尽有!

GPT的输出部分

最后的输出部分,作者配合动画解释了softmax,temperature,logits计算以及token选择等,语言简明扼要。

整个LLM可视化对于GPT推理整个流程可以说是从头到尾全覆盖了,对于想对GPT推理过程一探究竟的小伙伴是个非常合适的学习工具。随着OpenAI逐渐转向CloseAI,人们也更加关注LLM生成的内容,不再溯源这一切是如何发生的。ChatGPT也许很复杂,但其本质也可以很简单。

参考资料

https://bbycroft.net/llm https://cameronrwolfe.substack.com/p/language-model-training-and-inference

备注:昵称-学校/公司-方向/会议(eg.ACL),进入技术/投稿群

id:DLNLPer,记得备注呦

最新评论

推荐文章

作者最新文章

你可能感兴趣的文章

Copyright Disclaimer: The copyright of contents (including texts, images, videos and audios) posted above belong to the User who shared or the third-party website which the User shared from. If you found your copyright have been infringed, please send a DMCA takedown notice to [email protected]. For more detail of the source, please click on the button "Read Original Post" below. For other communications, please send to [email protected].

版权声明:以上内容为用户推荐收藏至CareerEngine平台,其内容(含文字、图片、视频、音频等)及知识版权均属用户或用户转发自的第三方网站,如涉嫌侵权,请通知[email protected]进行信息删除。如需查看信息来源,请点击“查看原文”。如需洽谈其它事宜,请联系[email protected]。

版权声明:以上内容为用户推荐收藏至CareerEngine平台,其内容(含文字、图片、视频、音频等)及知识版权均属用户或用户转发自的第三方网站,如涉嫌侵权,请通知[email protected]进行信息删除。如需查看信息来源,请点击“查看原文”。如需洽谈其它事宜,请联系[email protected]。