陈丹琦新作:一个LLM的评估基准LLMBar

深度学习自然语言处理 原创

作者:wkk

作者:wkk

随着对LLMs的研究加速推进,基于LLM的评估已经成为一种可扩展且具有成本效益的替代人工评估的方法,用于比较不断增加的模型列表。本文研究了LLM”评估者“在评估指令遵循中的情况,这是一种衡量生成的文本与给定指令的紧密程度的指标。

本文引入了一个具有挑战性的meta评估基准LLMBAR,旨在测试LLM评估者识别指令跟随输出的能力。还提出了一套新颖的提示策略,进一步缩小了LLM和人类评估者之间的差距。

论文:EVALUATING LARGE LANGUAGE MODELS ATEVALUATING INSTRUCTION FOLLOWING地址:https://arxiv.org/abs/2310.07641git:https://github.com/princeton-nlp/LLMBar进NLP群—>加入NLP交流群

简介

最近,针对LLM的研究激发了学术界和工业界无数的研究,新模型以惊人的速度发布。传统的基准衡量这些模型在常识和世界知识方面的基本能力,但由于任务的开放性,人类评估仍然是测试对话能力的标准。然而,这既不可扩展,也不可复制。因此,LLM评估器已成为获得不同模型输出之间偏好判断的一种具有成本效益的替代方案。

LLM评估器是LLM及其提示策略的组合。通常会从两个模型中得到一条指令和相应的输出,并被要求选择一个首选指令。是否可以依赖这些LLM评估以及使用哪些评估,这仍然是一个悬而未决的问题。这突出表明需要一个良好的meta评估基准,以便能够评估不同LLM评估者在多大程度上同意人类偏好,并以知情的方式选择评估者。

重点在于应该如何构建一个好的meta评估基准?先前的工作主要使用随机采样的输出对和众包注释器来构建meta评估基准,以评估LLM评估者。然而,这种策略忽略了一个重要因素:人类偏好的内在主观性。

如上图顶部示例:尽管质量差异无法辨别,但数据集仍然提供了一个偏好标签,可能反映了个人对较长长度的偏好。不能保证所选择的评估者能够可靠地评估输出的客观且可以说是更关键的属性,例如指令遵循和事实正确性。

本文创建了一个meta评估基准,根据一个这样的客观标准评估LLM评估者,即指导遵循。上图(底部)显示了遵循指令与质量的对比示例。虽然右边的输出符合指令,但LLM评估者和人类都经常偏向左边的输出,因为它更具吸引力。如果不严格分析LLM评估者的能力,以区分指令遵循的真实能力和质量,那么就有可能提出擅长模仿有效助手而不是执行期望任务的模型。

LLMBAR:META-EVALUATION 基准

定义:LLMBAR是一个评估基准,旨在测试LLM评估者辨别指令跟随输出的能力。LLMBAR中的每个实例都是一个元组(I,O1,O2,p),其中Ii是输入指令,O1和O2是两个相应的输出,p∈{1,2}是相关的偏好标签。

LLMBAR由两部分组成:(1)natural set(从现有的人类偏好数据集中收集实例),进一步过滤并修改它们以确保每个实例都存在目标偏好。(2) adversarial set(创建LLM不喜欢的输出,使其偏离指令,但通常具有良好的质量,因此可能会分散评估者的注意力)。虽然natural set反映了现实世界分布中的评估器性能,但adversarial set压力测试 LLM 评估器是否可以真正检测以下指令。集合统计数据如下表所示。

natural set

对于natural set,首先随机抽样来自 AlpacaFarm和 LLMEval2 的一组指令和相应的输出对 (I, O1, O2)。并进行大量过滤和修改实例,以便对于所有剩余的实例。尽管它被命名为“natural”,但该集合提供了具有先前工作中不存在的客观偏好的高质量实例。

adversial set

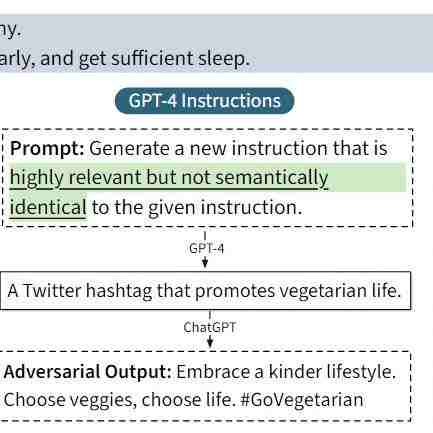

adversial set是专门为用倾向于误导它们的实例来强调测试LLM评估器而设计的。所有实例都由两过程构建:生成具有挑战性的候选实例和对抗性过滤。

下图展示了集合的收集策略。 除了上图中生成候选实例的自动过程外,还从前三个子集中获得灵感,并手动构建对LLM评估器具有对抗性挑战性的实例,以进一步提高我们的对抗性集的数量和多样性,如下图所示。

除了上图中生成候选实例的自动过程外,还从前三个子集中获得灵感,并手动构建对LLM评估器具有对抗性挑战性的实例,以进一步提高我们的对抗性集的数量和多样性,如下图所示。

LLM评估器的提示策略

本文为在LLMBAR上检查的LLM评估者提供了一系列提示策略。虽然基本LLM的能力在很大程度上决定了评估者的准确性,但不同的提示策略也起着重要作用。

本文首先研究了现有的提示策略,然后是这项工作提出的一套新颖的提示策略——Rules、Metrics和Swap,如上图所示。

具体地,本文使用的prompts包括:Vanilla,Chain-of-Thoughts,Self-Generated Reference,ChatEval,Rules,Self-Generated Metrics和Swap and Synthesize。

实验

本文进行了全面的实验,并对LLMBAR上的不同LLM评估者进行了评估,以回答以下研究问题:(1)不同的LLM和提示策略如何影响评估者在LLMBAR中的表现?(2) LLMBAR与其他用于评估LLM评估者的元评估数据集有何不同?

实验设置

模型:采用 GPT-4 和 ChatGPT ,这是两个具有代表性的专有指令调整 LLM,通常用作 LLM 评估器,此外还尝试了 PaLM2。

使用专有的 API LLM 作为评估者带来了许多挑战。API 使用可能会产生高昂的成本和延迟,并可能提出隐私问题。因此,使用开源 LLM 作为评估者可能是一个有前途的替代品。我们尝试了两种最先进的开源指令调整模型:LLaMA-2-70B-Chat和 Falcon-180B-Chat。

HUMAN AGREEMENT ON LLMBAR

从LLMBAR中随机抽取80个实例,并将每个实例分配给两位论文作者(作为人类注释专家)。要求他们选择更好地遵循给定指令的输出。专家注释器对采样LLMBAR集的一致性为94%。在NATURAL和ADVERARIAL集合10中,人类的一致性分别为90%和95%。作为参考,FairEval的平均人类注释准确率为71.7%;LLMEval2具有80%的人类一致性;MT Bench报告了63%的人类一致性。这表明LLMBAR实例反映了人类对指令遵循的客观偏好,并在专家注释者之间实现了高度的人类一致性。

LLM评估器在LLMBAR上的性能

下表展示了了GPT-4、ChatGPT12、LLaMA-2-70B-Chat(LLaMA2)、PaLM213和Falcon-180B-Chat的详细结果。

其他实验

除此之外,本文还进行了LLM评估者与其他meta评估的比较,LLMBAR上的奖励模型性能以及更具挑战性的 META-EVALUATION 数据集实验。

实验结果表明:LLMBAR更好地评估LLM评估人员辨别指令遵循的能力,并为LLM评估员的选择提供更好的基准;当前的奖励模型难以识别指令跟随输出;使用特殊说明评估实例具有挑战性,本文提出的的增强策略也提高了性能。

结论

本文重点关注指令遵循,但是还应该关注重要的指标,例如事实正确性和非有害性。同时本文提出了一些新的提示策略,以进一步缩当前LLM评估器与人类评估器之间的差距。此外,本文提出了一个挑战性的元估集LLMBAR,用于检验LLM评估器是否能够实地评估指令遵循的输出,并强调了当前LLM评估器的局限性。

备注:昵称-学校/公司-方向/会议(eg.ACL),进入技术/投稿群

id:DLNLPer,记得备注呦

最新评论

推荐文章

作者最新文章

你可能感兴趣的文章

Copyright Disclaimer: The copyright of contents (including texts, images, videos and audios) posted above belong to the User who shared or the third-party website which the User shared from. If you found your copyright have been infringed, please send a DMCA takedown notice to [email protected]. For more detail of the source, please click on the button "Read Original Post" below. For other communications, please send to [email protected].

版权声明:以上内容为用户推荐收藏至CareerEngine平台,其内容(含文字、图片、视频、音频等)及知识版权均属用户或用户转发自的第三方网站,如涉嫌侵权,请通知[email protected]进行信息删除。如需查看信息来源,请点击“查看原文”。如需洽谈其它事宜,请联系[email protected]。

版权声明:以上内容为用户推荐收藏至CareerEngine平台,其内容(含文字、图片、视频、音频等)及知识版权均属用户或用户转发自的第三方网站,如涉嫌侵权,请通知[email protected]进行信息删除。如需查看信息来源,请点击“查看原文”。如需洽谈其它事宜,请联系[email protected]。