【速览】CVPR 2020| SRN:从“看见”到“看懂”, 语义推理网络助力图文识别模型重磅升级

学会“成果速览”系列文章旨在将图像图形领域会议期刊重要成果进行传播,通过短篇文章让读者用母语快速了解相关学术动态,欢迎关注和投稿~

◆ ◆ ◆ ◆

Towards Accurate Scene Text Recognition with Semantic Reasoning Networks

Deli Yu, Xuan Li, Chengquan Zhang, Tao Liu, Junyu Han, Jingtuo Liu, Errui Ding

CVPR 2020

撰稿人:百度视觉技术部

推荐理事:金连文、林宙辰

◆ ◆ ◆ ◆

本文简要介绍CVPR2020录用论文 “Towards Accurate Scene Text Recognition with Semantic Reasoning Networks” 的主要工作。该论文围绕自然场景文本识别,针对语义信息利用受限、解码效率低的等问题,提出了语义推理模块Global Semantic Resoning Module (GSRM)用于实现全局语义信息推理,并在此基础上,提出了端到端的语义推理网络Semantic Reasoning Networks (SRN),可以融合视觉特征与语义特征。SRN在英文规则文本行、不规则文本行和中文长文本行数据集上都取得SOTA的效果。另外,SRN在训练和推断阶段,字符与字符之间是并行的,相比于Attention based方法有2倍的加速。

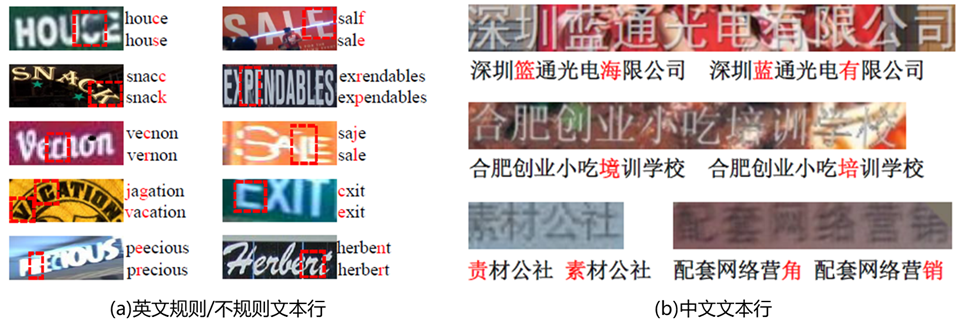

Figure 1. SRN的识别结果,证实了语义模块GSRM的有效性。在(a)中图像右侧顶部文本行是纯视觉的识别结果,图像右侧底部文本行是SRN识别结果。在(b)中图像下方靠左的文本行是纯视觉的识别结果,图像下方靠右的文本行是SRN识别结果。

场景文本图像包含2种层次的内容:视觉信息和语义信息。近些年来的致力于提高识别性能的工作大多从提取鲁棒且有效的视觉特征的视角出发,例如升级模型Backbone[1,2],增加矫正模块[3,4],校准Attention机制[1,5]等,然而却忽视了改进语义特征。然而,场景文字识别不单依赖视觉感知信息,也依赖高层次的语义信息的认知理解,例如Figure 2.所示 ,仅依靠视觉信息很难单独识别分离抽取出的字符图像,尤其是(b)中红框标出的字符;相反地,当结合整个单词的语义信息时,可以很容易识别整个单词。

Figure 2. 现实生活中的场景文本图像 (a)是较难识别的场景文本图像,(b)是从(a)中图像里分离抽取出的字符图像,(c)是(a)中图像对应的语义内容。

就获取语义信息的方式而言,主流的Attention based方法基于RNN来实现,是一种采用单向串行方式[1,3,4]进行建模的方法,如Figure 3. (a)所示。这种方式有明显的不足:

1)仅仅感知了历史时刻的语义信息,而无法获取未来时刻的语义信息;

2)如果较早时刻解码出的错误字符,会为余下时刻的解码传递错误的语义信息,导致误差积累效应;

3)串行的解码模式是相对低效的,特别是在模型预测的环节。

Figure 3. 两种不同的传递语义信息的方式。(a)是单向串行方式;(b)是全局并行方式

Figure 4. SRN的结构图。灰色表示并行的数据流

本文提出的端到端可训练的SRN由四部分组成:基础网络Backbone、并行的视觉特诊提取模块(PVAM)、全局语义推理模块(GSRM) 和视觉语义融合的解码器(VSFD)。给定一张输入的文本图像,基于ResNet50 + Transformer unit的Backbone从中提取出视觉2D feature map V;之后PVAM会针对每个目标字符获取其相应的视觉特征G;GSRM会基于视觉特征G获取全局语义信息,并转化为每个目标字符的语义特征S;最后VSFD融合对齐的视觉特征和语义特征,预测出相应字符。在训练阶段和推断阶段,每个序列中各个字符之间是并行。

- PVAM原理介绍

在Backbone输出了2D的视觉feature map之后,传统Attention based decoder机制需要上一时刻的隐变量 和预测结果 来引导当前时刻解码,前面已经介绍这种方式所引起的不足。

为了打破传统Attention机制的时间依赖特性,PVAM会针对文本行中的每个字符,计算出相应attention map ,通过将其与feature map逐像素加权求和,我们便得到每个目标字符对应的的视觉特征 。另外,PVAM也用字符的阅读顺序 取代上一时刻隐变量 来引导计算当前时刻的attention map ,如下公式。这样PVAM打破了时间依赖,实现了并行提取视觉特征的目的。

这里, 是通过对目标字符阅读顺序进行embedding获取的,例如对于“COFFEE”而言,各个字符对应的 就是由[0,1,2,3,4,5]进行embedding得到的。

GSRM原理介绍

GSRM会基于全局语义信息进行推理,将视觉特征G转化为语义特征S。传统Attention机制对序列概率的建模方式可以用下式所示。通常我们会采用类似于RNN的递归结构,来对这一公式进行建模。RNN结构会以单向串行方式隐含捕获语义信息。 为了克服单向语义传播的缺点,GSRM通过引入和时间无关的近似语义embedding向量来对上式进行改造。通过引入,一方面,可以代替时序依赖的真实字符语义embedding向量;另一方面,由于去掉了时序依赖的,这样也可以独立获取,不依赖于时序;另外,优于的时序独立性,我们可以很容易的获取各个时刻的用于对当前时刻进行建模。这样,整个表达式可以被改造成下式,其中 是捕获全局语义信息的关系的函数, 是对齐的视觉特征, 是label字符。基于上式,我们构建的GSRM模块会主要实现两个功能:1、生成时间无关的近似语义embedding向量 ;对 进行建模,提取相应的语义特征

GSRM的结构如下图所示。Visual-to-semantic embedding子模块将视觉特征转化为语义特征,用交叉熵损失的约束视觉特征,对其概率分布取Argmax做预分类,分类字符嵌入到语义空间得到近似的语义特征向量 ;Semantic reasoning子模块以多层的transformer unit实现了 函数的功能,同时捕获了全局语义信息,获得相应目标字符的语义特征向量 。同时,也对 施加了交叉熵损失的约束,加快其收敛速度。

Figure 5. GSRM的原理图,从左到右依次是Visual-to-semantic embedding和Semantic reasoning子模块。

VSFD介绍

对PVAM输出的对齐的视觉特征 和GSRM输出的全局语义特征 ,VSFD采用Gate Unit方式做特征融合。最后,我们会基于融合后的特征进行预测输出。

该论文中对提出对SRN的各个模块进行了详细的消融实验,并在多个公开数据集上进行了效果验证,包括ICDAR13、ICDAR15,IIIT5K,SVT,SVTP,CUTE80数据集,在准确度上取得了SOTA或者可比的结果。同时,也在中文长词数据集合TRW上与主流方法做了精度对比,证明了该方法对于中文的适用性。另外,在速度方面,也在同主体网络的限制下,与Attention和CTC等主流文字识别方法进行了速度对比。

公开数据集合对比

Table 1. SRN在ICDAR13、ICDAR15,IIIT5K,SVT,SVTP,CUTE80上的实验结果

Table 2. SRN在TRW中文数据集上的实验结果

预测速度

Table 3. SRN在IC15和TRW-L集合上的预测速度

本文认为对于场景文本识别系统而言,语义信息是十分重要的。为此,本文提出了全局语义推断模块(GSRM),以并行的方式来捕获全局语义信息,这种方式与基于RNN的单向串行方式相比,运行效率更高效、鲁棒。基于GSRM,本文提出了一个完整的端到端的可训练的语义推理网络SRN,用于实现视觉和语义信息的融合训练和预测。同时,由于SRN中各个模块都是非时序依赖的,因此,在训练和预测阶段,SRN都可以并行运行。未来我们会聚焦与提升GSRM模块的效率,同时让GSRM可以自由接入CTC等语义独立的OCR框架中,提升整个方案的应用价值。

Towards Accurate Scene Text Recognition with Semantic Reasoning Networks 论文地址:https://arxiv.org/pdf/2003.12294v1.pdf(点击“阅读原文”下载)

[1] Zhanzhan Cheng, Fan Bai, Yunlu Xu, Gang Zheng, Shiliang Pu, and Shuigeng Zhou. Focusing attention: Towards accurate text recognition in natural images. In ICCV, pages 5076–5084, 2017.

[2] Minghui Liao, Pengyuan Lyu, Minghang He, Cong Yao, Wenhao Wu, and Xiang Bai. Mask textspotter: An end-toend trainable neural network for spotting text with arbitrary shapes. IEEE transactions on pattern analysis and machine intelligence, 2019.

[3] Baoguang Shi, Xinggang Wang, Pengyuan Lyu, Cong Yao, and Xiang Bai. Robust scene text recognition with automatic rectification. In CVPR, pages 4168–4176, 2016.

[4] Baoguang Shi, Mingkun Yang, Xinggang Wang, Pengyuan Lyu, Cong Yao, and Xiang Bai. Aster: An attentional scene text recognizer with flexible rectification. IEEE transactions on pattern analysis and machine intelligence, 2018.

[5] Zbigniew Wojna, Alexander N Gorban, Dar-Shyang Lee, Kevin Murphy, Qian Yu, Yeqing Li, and Julian Ibarz. Attention-based extraction of structured information from street view imagery. In ICDAR, volume 1, pages 844–850. IEEE, 2017.

NCIG 2020

会议相关快速通道

往期精选

通知

2020年“CSIG图像图形中国行”承办方征集

通知

中国图象图形学学会关于延期召开近期相关学术活动的通知

倡议

中国图象图形学学会致全体会员的倡议书

速览

【速览】TIP2020 | 基于通道交互损失函数的细粒度图像分类方法

-长按注册会员-

-立享会员优惠-

关键词

模型

方法

论文

图像

方式

最新评论

推荐文章

作者最新文章

你可能感兴趣的文章

Copyright Disclaimer: The copyright of contents (including texts, images, videos and audios) posted above belong to the User who shared or the third-party website which the User shared from. If you found your copyright have been infringed, please send a DMCA takedown notice to [email protected]. For more detail of the source, please click on the button "Read Original Post" below. For other communications, please send to [email protected].

版权声明:以上内容为用户推荐收藏至CareerEngine平台,其内容(含文字、图片、视频、音频等)及知识版权均属用户或用户转发自的第三方网站,如涉嫌侵权,请通知[email protected]进行信息删除。如需查看信息来源,请点击“查看原文”。如需洽谈其它事宜,请联系[email protected]。

版权声明:以上内容为用户推荐收藏至CareerEngine平台,其内容(含文字、图片、视频、音频等)及知识版权均属用户或用户转发自的第三方网站,如涉嫌侵权,请通知[email protected]进行信息删除。如需查看信息来源,请点击“查看原文”。如需洽谈其它事宜,请联系[email protected]。