万一…人工智能算法不听话会怎么样?

编译/温璐菲

原作/Roman V. Yampolskiy

原文/Harvard Business Review

当你想要把人工智能融入到公司业务里的时候,可要想想清楚:可能会出什么乱子?我们的产品和服务的预期目标是什么?如果AI技术无法达到预期该怎么办?有没有减灾对策?

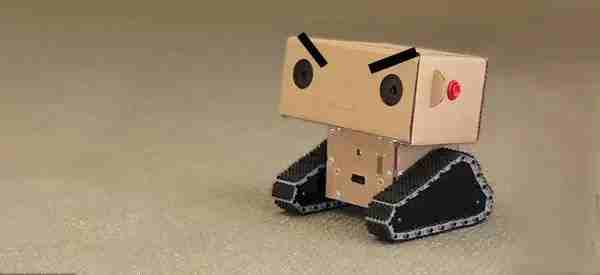

还记得微软推出的聊天机器人Tay吗?

微软聊天机器人Tay

网民们利用了这只机器人代码的缺陷,向它灌输了种族歧视、恐同和性别歧视的内容,并在社交网络上散布开来。这让微软陷入了非常尴尬的地位中。

由于被网民灌输了各种歧视内容,Tay最终下线

在刚刚投入使用的时候,软件和工业机器人就惹出过许多麻烦。但是这些事故的根本原因不是系统本身,而是系统本想要展现出的“智能”。系统可能会无法学习设计师让他学习的内容,反而去学习了其他高度相关的东西。

一个经典案例是:美军使用了一种电脑视觉系统来自动检测伪装好的敌军坦克,系统本应该识别的是坦克的图片,事实上却只学会了分辨这些图的背景。

另一个例子是,一些设计失当的函数会鼓励AI做出一些虽然能带来短期益处,却没有意义的举动,比如暂停游戏来避免失败,或者重复碰球来得控球的分数。

为了了解AI可能发生的问题,并且提前准备好预防和迅速善后的方案,我们可以研究一下近些年来人工智能发生的问题。

2015年:

- 自动邮件回复机写出了不合礼仪的邮件,比如说给工作伙伴表白。

- 一个抓取汽车零件的机器人误操作致人类死亡。

- 标记图片的软件把黑人分类为大猩猩。

- 医用AI把患有哮喘的病人诊断为致死率较低的肺炎。

- 成人内容过滤器失效,导致儿童接触到了暴力与性的内容。

电影《机器姬》中AI最终欺骗人类

2016年:

- 用来防止累犯的AI系统发生了种族歧视的问题。

- 视频游戏的NPC自行创造了未经授权的超级武器。

- AI对选美比赛进行评分,给深色人种的评分偏低。

- 保安机器人与儿童发生冲突,并有暴力行为。

- “AlphaGo”在世界级围棋比赛中输给了人类。

- 自动驾驶汽车发生事故,致人类死亡。

《西部世界》中AI最终枪击了人类

在每天的日常生活中,人工智能的失误已经越来越普遍:垃圾邮件过滤器反而拦截了重要的邮件,GPS无法提供正确方向,机器翻译结果一团糟,自动修正把正确的词语换错,语音软件无法识别语音。总地来说,我们很难找到人工智能完美运行的例子。

分析了以上的AI失误案例,我们可以得到一个简单的结论:被设计用来做X任务的AI通常最后都会无法执行X任务。虽然这个结论非常简单,但是它确实可以对未来作出强有力的预测。比如:

- AI医生会犯人类医生不会犯的错误,发生误诊。

- 视频描述软件会误解电影情节。

- 写笑话的软件会写出一点都不好笑的笑话。

- 检测讽刺言论的软件会混淆嘲讽和真正的论述。

- 筛选雇员的软件会产生系统系偏见,雇佣到错的人。

- 火星探索机器人会误判环境,跌入火山口。

- 算税软件弄错减除额。

Google无人车遭遇车祸

我们能从以上例子中学到什么呢?

- 人工智能犯错是不可避免的!但是我们仍然可以事先做一些预防工作:

- 控制用户对系统的输入,只学习已经审查过的输入数据。

- 检查算法中对种族、性别、年龄等的歧视。

- 仔细分析软件会犯错的地方,并提供相应的安全机制。

- 提供一些无关“智能”的备用产品或服务。

- 准备好危机发生时的沟通方案(提示:一定要先道歉)。

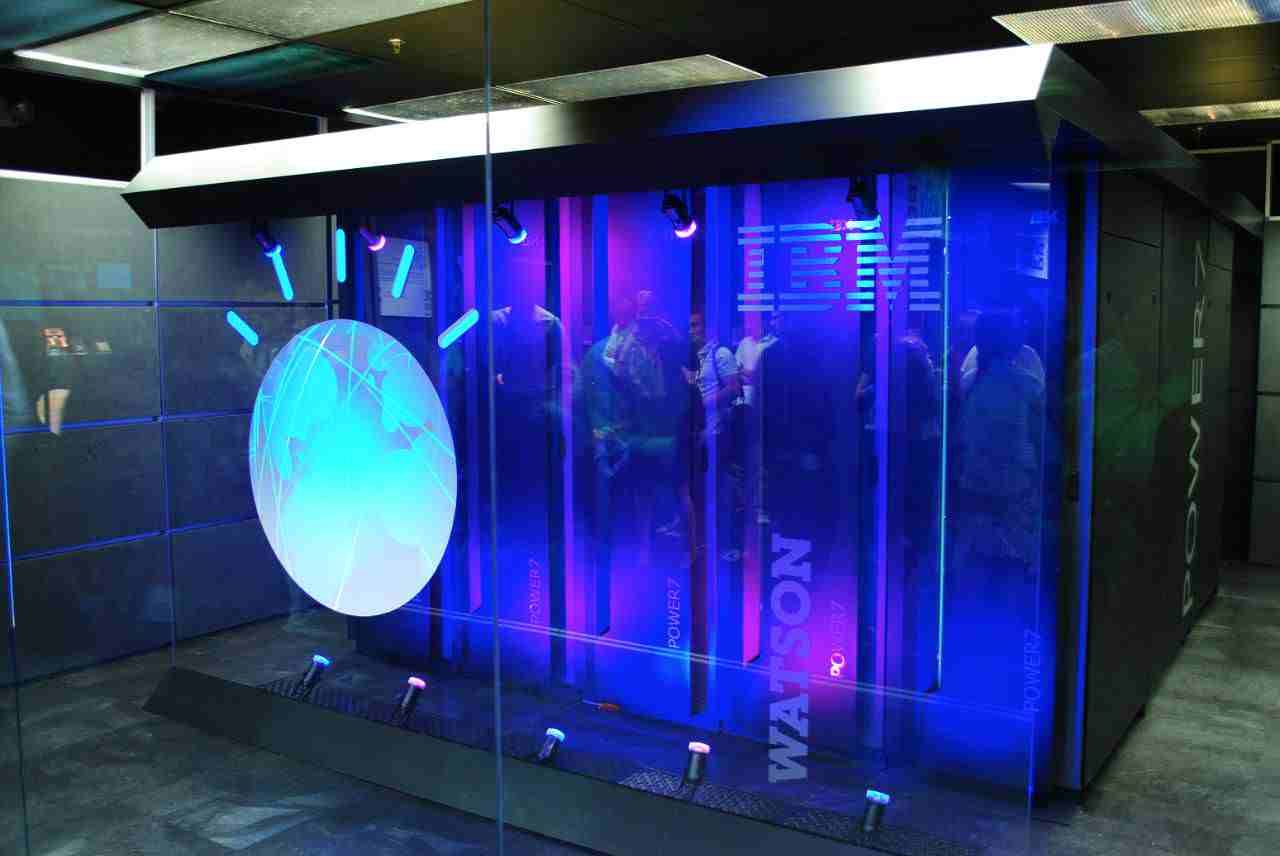

IBM研发的Watson可以辅助医生决策

可以预测,随着AI能力的扩展,随之而来的失误频率和严重程度也会稳步上升。如今,AI应用的领域还比较窄,所以发生的问题只是冰山一角。在今后,人工智能应用到交叉领域的时候,尴尬的失误越来越多。

精选文章推荐:

最新评论

推荐文章

作者最新文章

你可能感兴趣的文章

Copyright Disclaimer: The copyright of contents (including texts, images, videos and audios) posted above belong to the User who shared or the third-party website which the User shared from. If you found your copyright have been infringed, please send a DMCA takedown notice to [email protected]. For more detail of the source, please click on the button "Read Original Post" below. For other communications, please send to [email protected].

版权声明:以上内容为用户推荐收藏至CareerEngine平台,其内容(含文字、图片、视频、音频等)及知识版权均属用户或用户转发自的第三方网站,如涉嫌侵权,请通知[email protected]进行信息删除。如需查看信息来源,请点击“查看原文”。如需洽谈其它事宜,请联系[email protected]。

版权声明:以上内容为用户推荐收藏至CareerEngine平台,其内容(含文字、图片、视频、音频等)及知识版权均属用户或用户转发自的第三方网站,如涉嫌侵权,请通知[email protected]进行信息删除。如需查看信息来源,请点击“查看原文”。如需洽谈其它事宜,请联系[email protected]。