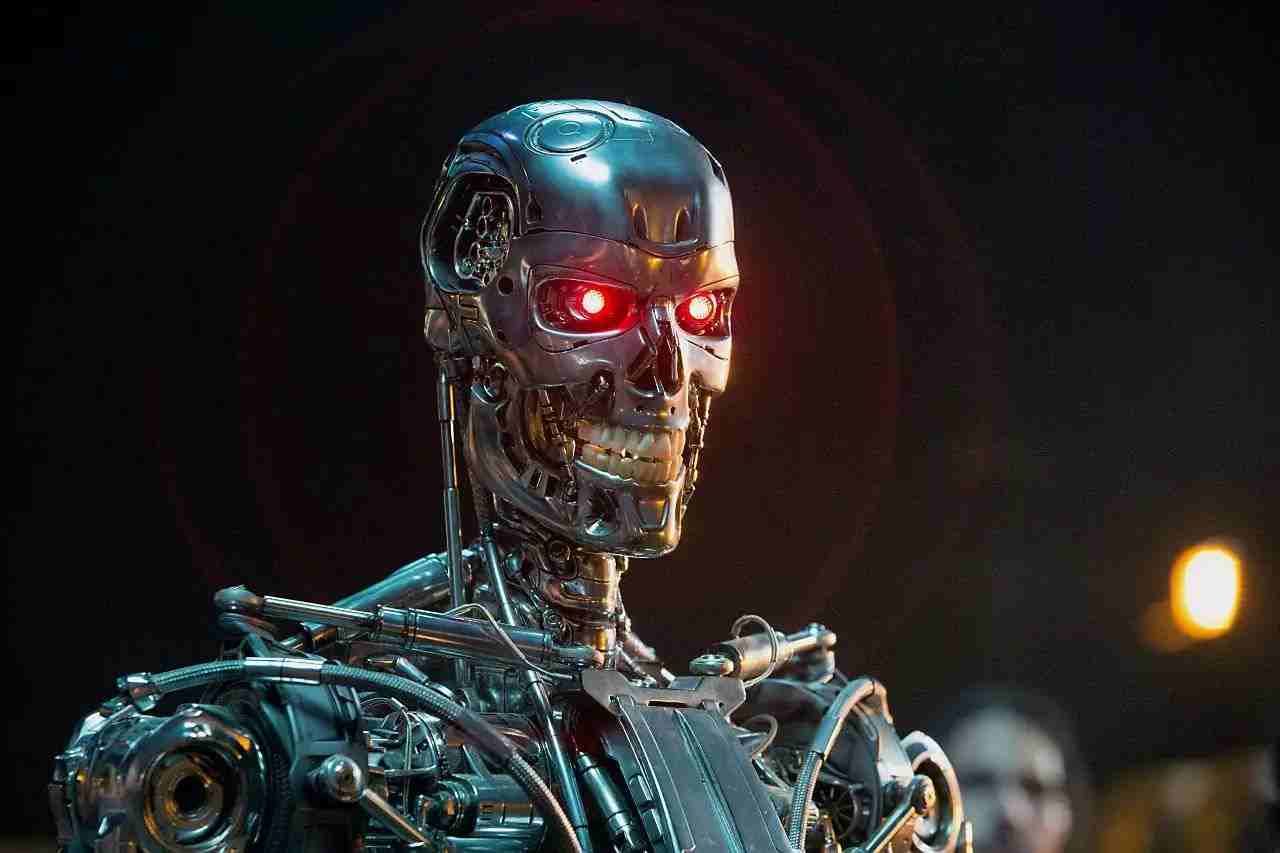

“终结者”AI离我们还有多远?

“

机遇只偏爱有准备的头脑,所以,有必要把可能性都探索个遍。

——劳伦斯·克劳斯

我们是否应对人工智能(AI)的潜在风险感到担忧?

最近,我带着这个问题请教了多位AI研究人员,却发现他们的回答大相径庭,几无共识。

而非专业人士更是陷入云里雾里。

问题之一在于,“人工智能”这个词范畴宽泛、模棱两可。它既可以指扫地机器人,又可以指自动驾驶卡车,还可以指电影《终结者》中那种掌握生杀大权的机器人。

概括起来,AI可分为三种:弱AI、强AI,以及超级智能。

现在所有的AI都只能算是弱AI。从理论上讲,强AI和超级智能的实现是有可能的,但现在还为时尚早。

要分析AI的风险与裨益,我们有必要理解不同形式AI之间的差别。不同类型的AI牵扯出的潜在风险大不相同,有的无关紧要,有的则非同小可。

以下几个概念界定可帮助我们厘清头绪。

弱AI

狭义人工智能(常被称为弱AI)是一种算法智能,或称专业化智能,几年前就已诞生。

比如完败国际象棋世界冠军加里·卡斯帕罗夫(Garry Kasparov)的“深蓝”计算机,或是iPhone的Siri,乃至语音识别与处理软件。这些都是应用范围相对狭窄的无意识智能。

将弱AI 也归为人工智能似乎不大合适,因为虽然它可在单项任务上完胜人类,但它所有的能耐也仅限于此。

弱AI没有自我意识,不会自设目标,因此,也不会构成什么末日威胁。但考虑到弱AI控制着保持人类文明存续的至关重要的软件,我们还是非常依赖它。

强AI

通用人工智能(常被称为强AI)是一种通用系统,又被称为“思维机器”。

从理论上讲,通用人工智能在完成任务层面上和人类不相上下,甚至有时还能更胜一筹;它可以自主思索、推理,并以多种多样的方式解决复杂问题。

强AI是否具备“意识”,这个问题仍存争议。

至少,它能展现出通常与意识密不可分的行为——常识推理、对自然语言的理解力、创造力、策略制定和一般智能行动。

通用人工智能尚未诞生,业界普遍认为或许还要20年。与其同时,几乎所有人也都承认,那一天终将到来。

比如由微软联合创始人保罗·艾伦创立的人工智能研究所(Allen Institute for Artificial Intelligence)及世界各地的其他诸多机构,都在逐渐朝这个目标前进。

此类AI势必涉及到更多的复杂问题,然而,反乌托邦式科幻作品中的大反派还轮不到它来当。

强AI的目标就是达到一般的人类智能水平;除非它在短时间内快速展开递归式的自我改进,否则,它不太可能对人类生命构成灾难性的威胁。

强AI的主要问题涉及经济和文化层面,比如:自动化导致的就业流失,经济原因导致的人口迁移,隐私与数据管理,软件安全漏洞等。

超级智能

最后是超级人工智能。

在2014年的一次访谈中,牛津大学哲学家尼克·博斯特罗姆(Nick Bostrom)将其定义为“在各个领域都力压人类的任何智能,这些领域包括科学创造力、一般智识与社交技巧。”

人们在担心AI的危险性时,指的就是这一类型的AI(超级人工智能)。

用博斯特罗姆的话来说,一台真正超级智能的机器会“变得极其强大,以至于能按自己的喜好塑造未来。”

到目前为止,完善的超级智能还遥不可期,但在巨大的激励推动下,研究工作正在持续推进。

经济激励是显而易见的:率先推出超级人工智能的公司将坐拥巨额利润。在政治与军事层面,这一技术的应用前景不可限量。

各国都在争做第一,乃至认为这将是赢者通吃的局面。换言之,科技军备竞赛已然打响。

那么问题来了:我们距这种技术的降临还有多远?它将给人类生活带来怎样的影响?

当初为撰写《超级智能》一书,博斯特罗姆曾向该领域内的顶尖专家提问,其中之一是:“你觉得到哪一年,比肩人类的人工智能可达到50%?”

将所有答案取中位数,结果落在2040至2050年之间,这当然只是预测,但给了我们一个大致的概念。

超级智能的诞生时日难以预测,但相对确定的一点是,它总有一天会实现。

如果智能就是关乎信息处理,如果我们持续提升计算系统的处理容量与速度,那么,超级智能的诞生似乎不可避免。

不论要等50年、100年还是300年,我们总会跨过那道门槛。

真到了那一天,这个世界将会发生什么样的变化,我们可能连做梦也想不到。

为什么需要担心?

面对各方面都完胜人类的超级智能,我们不能想当然地认为:我们一定驾驭得了。它很可能会提升自我,增强自己的实力。

超级智能机器有可能出现自我意识,产生自己的目的、野心。这种机器怎会乖乖地任人摆布?

如果超级智能开始为自己的目标而奋斗,它有可能产生不符合人类福祉的目标。

超级智能机器的行为将更加难以预料。这样一种存在究竟会想要什么?为什么会产生那样的欲求?它将以何种手段实现这些欲求?我们都不得而知。

可以大致确定的是,超级智能会将自己的需求置于人类需求之上。

也许可以这样说:它会对人类需求漠不关心,就好像人类对黑猩猩或短吻鳄的需求漠不关心:人类并非刻意要置黑猩猩和短吻鳄于死地,只是当我们的目标与次等智能生物的福祉产生冲突时,我们恰好造成了这样一种局面。

博斯特罗姆等人怕超级智能,怕的就是这个。

我们必须为这一不可避免的结果做好准备,他最近告诉我说,“出大问题也是完全有可能的,这必须引起我们的重视。”

翻译:雁行

来源:VOX

点击标题 查看往期回顾

最新评论

推荐文章

作者最新文章

你可能感兴趣的文章

Copyright Disclaimer: The copyright of contents (including texts, images, videos and audios) posted above belong to the User who shared or the third-party website which the User shared from. If you found your copyright have been infringed, please send a DMCA takedown notice to [email protected]. For more detail of the source, please click on the button "Read Original Post" below. For other communications, please send to [email protected].

版权声明:以上内容为用户推荐收藏至CareerEngine平台,其内容(含文字、图片、视频、音频等)及知识版权均属用户或用户转发自的第三方网站,如涉嫌侵权,请通知[email protected]进行信息删除。如需查看信息来源,请点击“查看原文”。如需洽谈其它事宜,请联系[email protected]。

版权声明:以上内容为用户推荐收藏至CareerEngine平台,其内容(含文字、图片、视频、音频等)及知识版权均属用户或用户转发自的第三方网站,如涉嫌侵权,请通知[email protected]进行信息删除。如需查看信息来源,请点击“查看原文”。如需洽谈其它事宜,请联系[email protected]。