总结 | Google Research大牛带你深度学习TensorFlow之第一堂课经典提炼

►特邀讲师

阮巨城博士

Software Engineer @ Google Research

Carnegie Mellon University Ph.D. in Computer Engineering

博士期间citation 223

台湾国立清华大学学士,曾服务于台湾中央研究院

►第一节课内容总结

►机器学习还是深度学习?

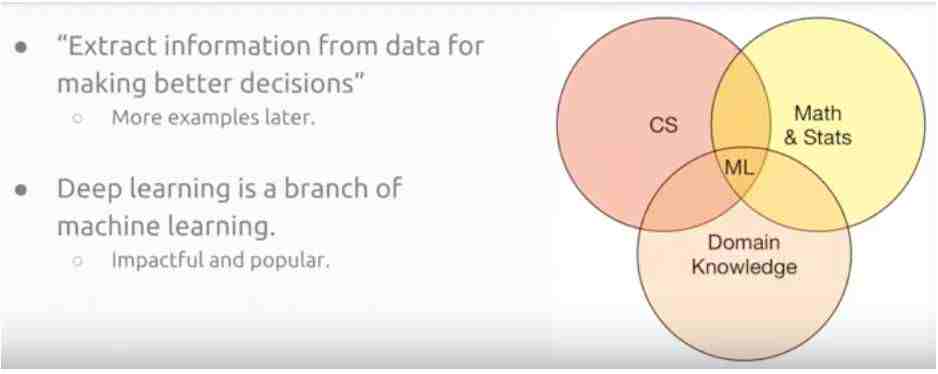

我们如何定义机器学习呢?在阮博士看来其实就是运用数据做出更好的判断。机器学习其实就是计算机科学,与基础的统计知识和到底如何处理问题的Domain knowledge的交叉点。

那么,深度学习事实上是机器学习的一个分支而已。

►为什么要用深度学习?从分类垃圾邮件到Alpha Go

很多人会说处理如何分类垃圾邮件这个简单的问题,其实用基本的机器学习,例如Logistic Regression, SVM 等也可以处理。为什么需要用深度学习?那答案就是深度学习的效果和准确度更高。很多原本用机器学习的应用现在也开始慢慢采用深度学习。

除此之外,现代电脑通过深度学习“Embedding space”等独有的功能,能够将文字embed到一个有语义的向量空间中,这就意味着计算机能够理解的语义范围变得更广了。

深度学习不断发展的现在,人工智能已经可以开始创作写诗。

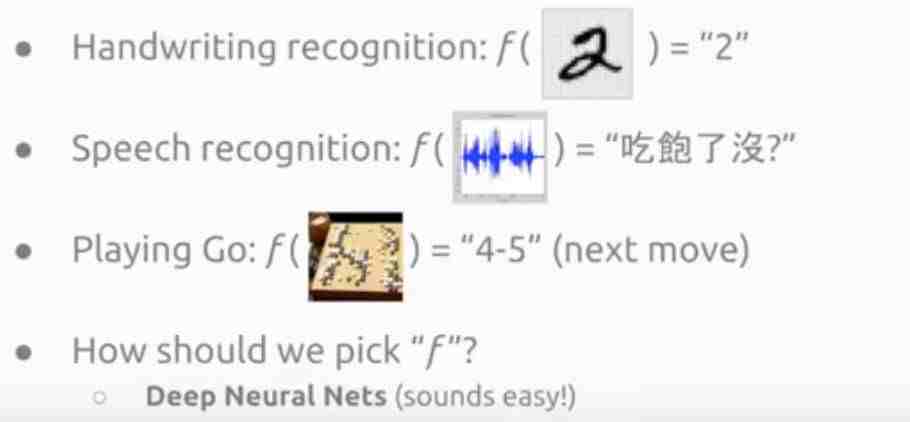

Alpha Go作为最有名的一个案例,其中有关深度学习一个非常重要的概念就是Convolutional Neural Network.在本次训练营中,我们将会对以上案例,以及包括字体识别,语音识别等多种深度学习实际应用背后的原理进行介绍。

►深度学习的背后到底是什么?

深度学习其实就是一种监督式学习,这种supervised learning 也是我们这次训练营学习的重点。归结到最后,Deep Learning其实就是一个运算规则,所以我们的问题就是如何选择这个function。

深度学习40年前其实就已经发展出来了,但是叫做Artificial Neural Network.但是为什么现在深度学习能够做出很好的效果,最主要有两个原因,一个是现在有效的数据比原来多了很多,另一个就是现在的运算能力比原来增强了很多。

►什么是Artificial Neuro Network,类神经网络?

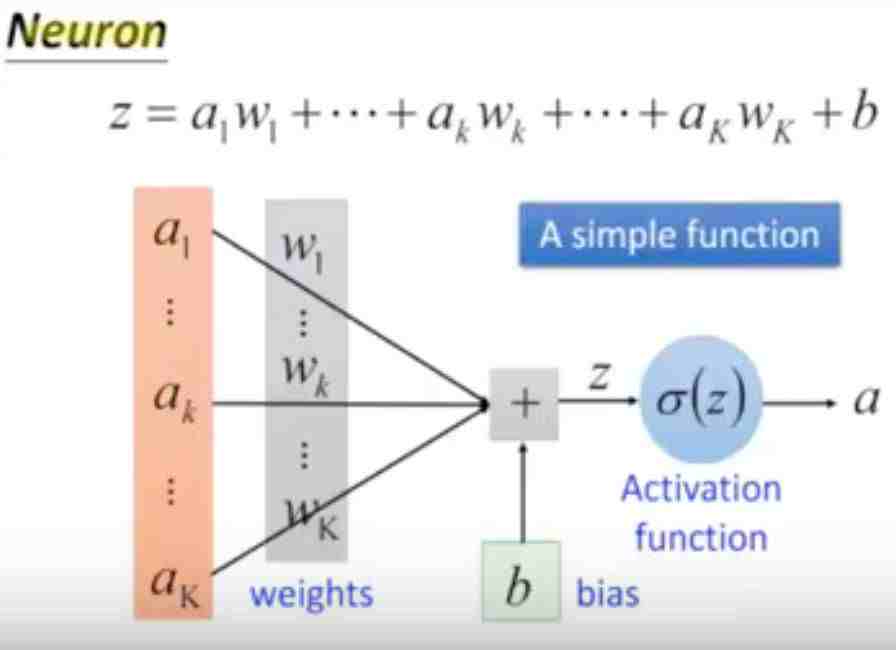

之后,阮博士对类神经网络做了详尽的介绍,包括人脑与机器大脑的区别。相较于人脑通过神经元,通过突触链接,进而形成神经网路。计算机的大脑组成依靠信息的传递与沟通。每一个信息作为一个输入(input),与其比重进行相乘,然后由Activation function,类似于一个“开关”,来决定是否继续传递。而很多个神经元叠放在一起就成为了电脑的神经网络。最后一层通过Softmax的转换成一个从0到1的概率输出。

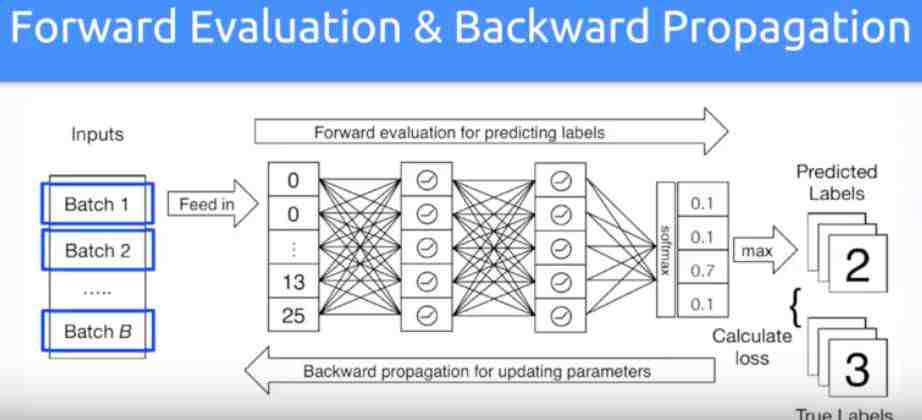

最后的如果将整个过程联系在一起看,便是下面的这个结果。包含两个过程,一个是Forward evaluation, 也就是从Input一层层传递信息到Softmax层得出概率结果。第二个过程就是Backward propagation,也就是如何改进中间的信息比重。

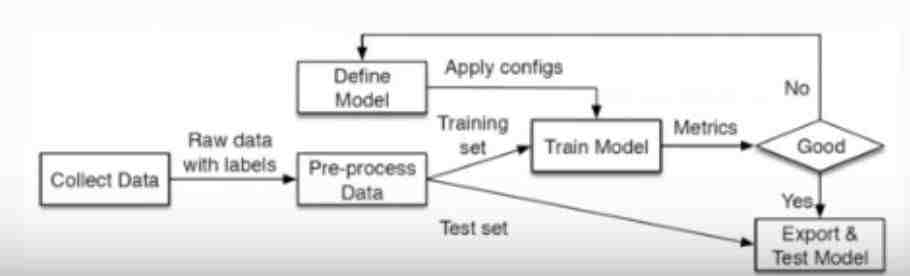

阮博士在此之后,深入浅出介绍了如何准备训练数据,以及深度学习数据分析的整体框架结构(如下图),并通过Tensorflow的案例展示如何神经网络进行分析。 更多干货,感兴趣的同学,请观看我们长达两个多小时的免费公开课。

(点击文末“阅读原文/Read More”观看完整视频)

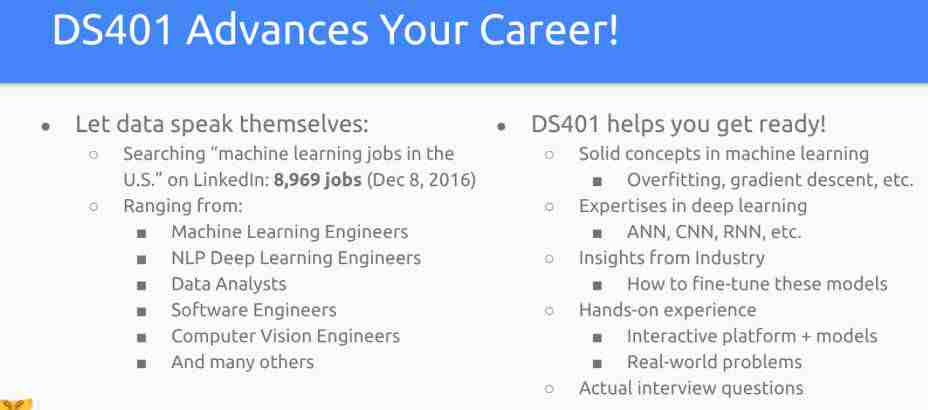

除了对深度学习核心技术的掌握与实作,本课程设计的实战也是让同学模拟在现实工作中,对deep learning project的处理步骤以及方法。让学员能够提前体验一个machine learning engineer 或 quantitative analyst 的生活以及 responsibility。阮博士在第一堂课的最后特别提到了Deep Learning领域工作的前景:

►关于课程

目标:让学员在最短时间内(小于8小时)理解并掌握深度学习技术,成为各大公司炙手可热的深度学习高手。

(1) 理论课:围绕深度学习重点概念(Activation Function, Forward Evaluation, Backward pro-agation等)介绍深度学习中缺一不可的各种要素

(2) 实战课: 利用Tensorflow 以及iPython动手建立你的第一个深度学习模组

►课程大纲

请在公众号后台回复“DS401”查看

►后续课程安排

第二堂课

学习目标:

具体理论课程安排:

训练 (train) Feedforward Neural Network 所需要的概念及技术

熟悉深度学习所生成的 embedding space 及经典应用: word embedding

讲解深度学习进阶模型: Convolutional Neural Network (CNN)

具体理论课程安排:

1. 训练 (train) Feedforward Neural Network 所需要的概念及技术

a. Minibatch

b. Stochastic gradient descent

c. Learning rate

d. Adagrad

2. 熟悉深度学习所产生的embedding space 及经典应用: word embedding

a. Understanding embedding space by using word embedding as example

b. Applications from word embedding

c. Variants to train a word embedding

3. 理解深度学习进阶模型: Convolutional Neural Network (CNN)

a. Why CNN for images?

b. Convolutional layer (filter)

c. Zero padding

d. Channels: grey-scale v.s. colorful images

e. Max-pooling

f. Flattening

项目课程安排:

1. 示范对资料及模型的操作:in TensorFlow + Keras。

a. Get familiar with MNIST dataset

b. Pre-process dataset

2. 设计、调整并部署FNN 深度学习模型 in TensorFlow + Keras。

a. Design network structure: tower v.s. pyramid

b. Change activation function: is ReLU the best?

c. Select loss function

d. Dropout: when, where and how often?

e. L1 and L2 Regularization: what are the effects?

3. 运用feedforward neural network 产生 word embedding

a. Get familiar with text representation and news dataset

b. Design and train a FNN

c. Examine the word embedding

第三堂课

学习目标:

设计、调整并部署Convolutional Neural Network 所需要的概念及技能

讲解深度学习进阶模型: Recurrent Neural Network (RNN)

展示RNN模型及其应用

具体理论课程安排:

1. 设计、调整并部署 Convolutional Neural Network 所需要的概念及技能

a. Selection of the number and size of filters

b. Variants: Inception-net

c. Variants: Res-net

d. Variants: DEVISE for co-training images and texts.

2. 讲解深度学习进阶模型: Recurrent Neural Network (RNN)

a. Network with memory

b. Gradient diminish and explosion

c. Gated Recurrent Unit (GRU)

d. Long Short-Term Memory (LSTM)

项目课程安排:

1. 示范设计、调整并部署CNN 模型 in TensorFlow + Keras。

a. Revisit MNIST dataset

b. Design convolutional layers (filters)

c. Visualize convolutional layers

d. Compare results

2. 分析并比较 CNN 所产生出的 embeddings。

a. Play with different CNN variants

3. 示范设计LSTM以及其最新应用:文章生成

►课程时间

第二堂课 1月21日 3小时

美西时间 周六 6PM-9PM

美东时间 周六 9PM-12AM

北京时间 周日(22日) 10AM-1PM

第三堂课 1月22日 3小时

美西时间 周日 6PM - 9PM

美东时间 周日 9PM - 12AM

北京时间 周一(23日)10AM - 1PM

►扫码加入课程咨询群

►联系课程负责人(备注:咨询深度学习)

Elaine

►课程主页

复制链接或点击“阅读原文”:

https://www.bittiger.io/livecourses/EHWon2WhtmembkCFv

最新评论

推荐文章

作者最新文章

你可能感兴趣的文章

Copyright Disclaimer: The copyright of contents (including texts, images, videos and audios) posted above belong to the User who shared or the third-party website which the User shared from. If you found your copyright have been infringed, please send a DMCA takedown notice to [email protected]. For more detail of the source, please click on the button "Read Original Post" below. For other communications, please send to [email protected].

版权声明:以上内容为用户推荐收藏至CareerEngine平台,其内容(含文字、图片、视频、音频等)及知识版权均属用户或用户转发自的第三方网站,如涉嫌侵权,请通知[email protected]进行信息删除。如需查看信息来源,请点击“查看原文”。如需洽谈其它事宜,请联系[email protected]。

版权声明:以上内容为用户推荐收藏至CareerEngine平台,其内容(含文字、图片、视频、音频等)及知识版权均属用户或用户转发自的第三方网站,如涉嫌侵权,请通知[email protected]进行信息删除。如需查看信息来源,请点击“查看原文”。如需洽谈其它事宜,请联系[email protected]。